La semana pasada completamos un nuevo curso de la materia Ingeniería de Software en UNTreF. Tuvimos 6 alumnos, todos completaron la cursada y 5 de ellos promocionaron la materia.

Debido al cambio de plan de estudio, este cuatrimestre fue el último en la modalidad actual pero a pesar de eso también hicimos algunas innovaciones en esta edición. Resulta que a partir del próximo año la materia se dicta en el contexto del nuevo plan de estudio en el cual es un materia de tercer año y no de quinto año como fue hasta el momento.

En lo personal creo que fue uno de los mejores cuatrimestres que tuvimos y creo que en gran medida fue por el grupo de alumnos. A diferencia de otros cuatrimestres creo que se generó una muy buena onda tanto en la relación entre los alumnos como también en la relación docente-alumno.

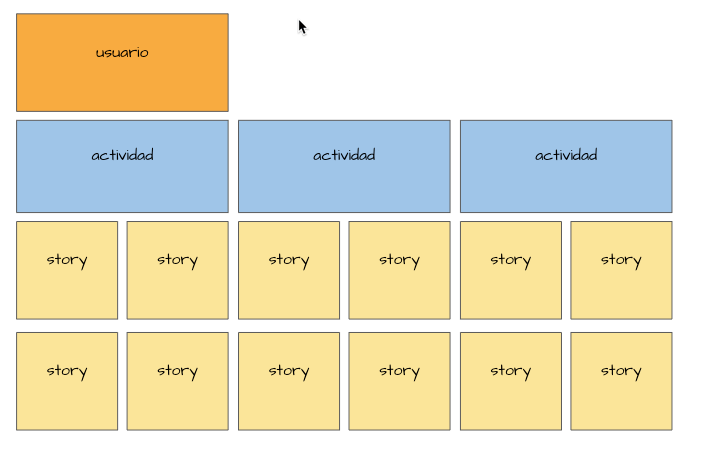

Como de costumbre trabajamos sobre el JobVacancy pero agregamos una innovación creando una capa de presentación complementaria representada por un Bot de Telegram. La introducción de este componente trajo un conjunto nuevo de complejidades que nos permitieron aplicar algunas prácticas más allá de las habituales (logs centralizados, monitoreo, gestión multipipeline, etc.)

En la retrospectiva de cierre los alumnos destacaron 3 cuestiones:

- Didáctica de la materia 🙂

- Contenidos de la materia 🙂

- Alta carga de trabajo (y agrego yo, carga continua de trabajo) 😐